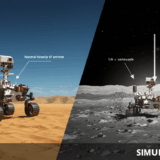

米国のAI企業Runwayが2025年7月25日に発表した動画編集AI「Runway Aleph」は、テキストプロンプトによる既存動画の編集を可能にする。Alephは従来のテキストから動画生成とは異なり、入力動画に対してオブジェクトの追加・削除、カメラアングル生成、スタイル・照明変更などの編集を実行する。同社のGeneral World ModelsとSimulation Modelsの研究に基づく会話型AIツールとして開発され、フレーム間の連続性を保持した編集が特徴である。

現在はエンタープライズ顧客とクリエイティブパートナーに早期アクセスを提供し、数日内に一般ユーザーへ展開予定である。また、OpenAIが2025年7月17日のライブストリームで発表したChatGPTエージェントは、o3モデルとOperatorを統合した個人アシスタントAIで、Pro・Plus・Teamユーザー向けに複雑なタスクを実行する。

From: Runway Launches New Aleph Model That Promises Next-Level AI Video Editing

Runway Launches New Aleph Model That Promises Next-Level AI Video Editing

【編集部解説】

innovaTopiaのAmiです。今回のRunway Alephについて、事実関係を精査した結果、記事の内容に誤認や誇張は見当たりませんでした。複数の信頼性の高いメディアや公式発表を確認し、この技術の真の革新性について解説させていただきます。

まず押さえておきたいのは、Runway Alephが従来のAI動画ツールとは根本的に異なるアプローチを取っている点です。OpenAI SoraやGoogle Veo、そしてこれまでのRunway Gen-3も「テキストから動画を生成する」いわば創造型でしたが、Alephは「既存動画を理解し編集する」編集特化型となります。この違いは、クリエイターの実際のワークフローを考えると極めて重要な進歩と言えるでしょう。

技術的な核心は「インコンテキスト動画モデル」にあります。これは、単一のモデルがオブジェクトの追加・削除、カメラアングル生成、スタイル・照明変更など、従来なら複数のツールを必要とした作業を統合的に処理できることを意味します。特に注目すべきは、フレーム間の連続性を保持しながら編集を行う能力で、これまでAI動画編集でネックとなっていた「チラつき」や「不自然な変化」の問題を大幅に軽減している点です。

この技術によって何ができるようになるのか。具体的には、既存の映像素材に対して「雨を降らせる」「昼を夜に変える」「余分な人物を削除する」「新しいカメラアングルを生成する」といった編集を、プロンプト入力だけで実現できます。これは、従来のVFXワークフローで数時間から数日を要していた作業を、文字通り分単位に短縮する可能性を秘めています。

ポジティブな側面として最も重要なのは、中小のクリエイターや制作会社にとっての参入障壁の劇的な引き下げです。高額なVFXソフトウェアや専門知識を持つスタッフを雇用せずとも、ハリウッド級の映像編集が可能になります。また、既存素材を活用する仕組みのため、完全に新規で動画を生成するよりも著作権やライセンシングの観点でリスクが低いことも利点です。

一方で、潜在的なリスクも存在します。最も懸念されるのは、既存映像の「真実性」に対する疑念の拡大です。この技術の普及により、どの映像が本物でどれが編集されたものかの判別が困難になる可能性があります。また、VFX専門スタッフの仕事への影響も長期的な課題となるでしょう。

規制面への影響としては、EU AI法をはじめとする各国の法的枠組みがより厳格化される可能性があります。特に、学習データの透明性や生成コンテンツの表示義務化などの議論が加速すると予想されます。

将来への影響を長期的視点で捉えると、Alephの登場は「動画編集の民主化」の次の段階を示しています。現在はエンタープライズ向けの早期アクセス段階ですが、一般ユーザーへの展開が進めば、YouTubeクリエイターから企業のマーケティング部門まで、動画コンテンツ制作の景色を一変させるでしょう。

特に重要なのは、この技術がRunwayの戦略的優位性を示している点です。OpenAI、Google、Metaといった大手が同分野に参入する中で、「編集特化」という明確な差別化により、プロフェッショナル市場でのポジションを確立しようとしています。これは、AI動画業界における競争の新たな局面を示唆しているのです。

【用語解説】

General World Models

現実世界の物理法則や空間的関係を理解し、動画内でのオブジェクトの相互作用や環境の変化を予測・モデル化するAI技術。

Simulation Models

仮想環境で現実世界の現象をシミュレーションし、動画生成や編集において一貫性のある変化を実現するAI技術。

インコンテキスト動画モデル

入力された動画の文脈や内容を理解し、その文脈に基づいて適切な編集を行うAI技術。従来の単純な生成型モデルと異なり、既存動画の内容を考慮して編集を実行する。

マルチタスク視覚生成

単一のAIモデルで複数の視覚的な生成・編集タスクを同時に処理する技術。オブジェクトの追加・削除・変形、カメラアングル生成、スタイル変更などを統合的に実行できる。

o3モデル

OpenAIが開発した推論能力に特化したAIモデル。複雑な論理的思考や分析を要するタスクを段階的に処理する能力を持つ。

エージェント型AI

自律的にタスクを実行し、複数のツールやサービスを連携させて複雑な作業を完了するAI技術。ユーザーの指示に基づいて独立して行動する。

Fluid

Editing動画編集において、自然で連続性のある変化を実現する技術概念。フレーム間の整合性を保ちながら、オブジェクトや環境の変更を滑らかに行う編集手法。

【参考リンク】

Runway公式サイト(外部)

AI動画生成・編集プラットフォームRunwayの公式サイト。最新のAI技術とクリエイティブツールを提供

Runway Aleph公式発表(外部)

Runway Alephの詳細な技術解説と使用事例を紹介する公式リサーチページ。技術仕様やデモ動画を確認

OpenAI公式サイト(外部)

ChatGPTエージェントを開発したOpenAIの公式サイト。最新のAI技術と製品情報を提供

OpenAI ChatGPTエージェント公式発表(外部)

ChatGPTエージェントの公式発表ページ。機能詳細や使用方法について確認できる

【参考記事】

Introducing Runway Aleph – Runway Research(外部)

Runway公式によるAlephの技術詳細とデモンストレーション。インコンテキスト動画モデルの仕組みを詳しく説明

OpenAI ChatGPT Agent公式発表(外部)

OpenAI公式によるChatGPTエージェントの発表記事。o3モデルとOperatorの統合技術について解説

【編集部後記】

皆さんは動画編集にどのような未来を描いていますか?

Runway Alephのような技術が一般化すれば、私たちが普段SNSに投稿する動画も、まったく新しい表現の可能性を秘めることになります。一方で「本物」と「編集済み」の境界線が曖昧になる時代でもあります。クリエイターとして、また情報の受け手として、この技術をどう活用し、どう向き合っていけばよいでしょうか?

皆さんのお考えや体験があればぜひお聞かせください。innovaTopia編集部も一緒に考えていければと思います。