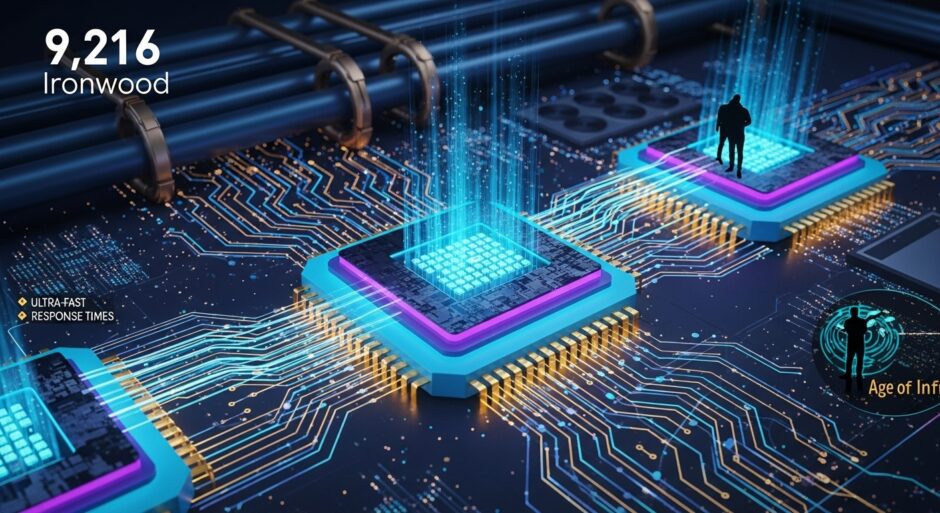

Google Cloud は11月6日、第7世代 Tensor Processing Unit「Ironwood」と拡張された Arm ベースのコンピューティング選択肢を発表した。Ironwood は前世代比で 4 倍以上のパフォーマンス向上を実現し、単一ポッドで最大 9,216 個のチップを接続可能である。Anthropic は最大 100 万個の TPU チップへのアクセスをコミットし、数十億ドル規模の複数年契約となる。2026 年にはギガワット超の容量がオンラインになる予定である。Google は同時に Arm ベースの CPU「Axion」の新インスタンスタイプ N4A と C4A metal を発表した。N4A は x86 ベース仮想マシン比で最大 2 倍の価格性能を提供する。Vimeo は N4A テストで 30% のパフォーマンス改善を、ZoomInfo は 60% の価格性能改善を報告した。Google は ±400 ボルト直流電力配信とギガワットスケールの液体冷却システムを展開しており、液体冷却システムは 99.999% の可用性を実現している。Ironwood Pods は次に最も近い競争者比で 118 倍の FP8 ExaFLOPS を提供する。

From:  Google debuts AI chips with 4X performance boost, secures Anthropic megadeal worth billions

Google debuts AI chips with 4X performance boost, secures Anthropic megadeal worth billions

【編集部解説】

このニュースで注目すべきは、AI業界が「トレーニング」から「推論(inference)」へと重心を移している転換点を象徴している点です。トレーニングはAIモデルに知識を学習させるプロセスで、比較的時間がかかっても問題ありません。一方、推論は学習済みモデルを実際に使用して応答を生成する段階で、リアルタイム性と安定性が求められます。ChatGPTやClaudeのような対話型AIが世界中で何百万人ものユーザーに同時に応答する場合、この推論処理の効率が事業の成否を分けます。

Googleの戦略で特筆すべきは、Nvidiaへの依存を減らすカスタムシリコンの経済性です。業界分析によれば、GoogleはTPUを自社開発することで、Nvidia GPUを購入する場合と比較して約5分の1のコストでAI処理能力を獲得できていると推定されています。これは単なるコスト削減ではなく、APIの価格設定や大規模展開の持続可能性に直結する構造的な優位性となります。

Anthropicとの契約規模も異例です。100万チップという数は、通常の大規模クラスターの20倍から100倍に相当します。2026年に「ギガワット超」の容量という表現は、小都市の電力消費に匹敵する規模感を示しています。AIインフラがもはや単なるITシステムではなく、電力・冷却を含む都市インフラに近い性質を持ち始めていることを物語ります。

記事で言及される ±400ボルト直流配信やラックあたり1メガワットという数字は、従来のデータセンター設計からの劇的な飛躍です。Googleが電気自動車のサプライチェーンを活用すると述べている点も示唆的で、AI時代のインフラが自動車産業や電力網と統合されつつある現実を反映しています。

一方でリスクも存在します。カスタムチップ開発には数十億ドルの先行投資が必要で、AIモデルのアーキテクチャが急速に進化する中で、特定のモデルに最適化されたチップが時代遅れになる可能性があります。また、Nvidiaの15年以上の蓄積があるCUDAエコシステムと比較すると、TPUのソフトウェア環境は発展途上です。

興味深いのは、Anthropicがマルチクラウド戦略を明言している点です。同社はGoogle TPU、Amazon Trainium、Nvidia GPUを使い分けており、単一ベンダーへの依存を避けています。これは今後のAI企業にとって重要な指針となるでしょう。

日本企業への示唆として、このインフラ競争はクラウドサービスの選択だけでなく、自社のAI戦略全体に影響します。推論コストの大幅な削減は、これまで経済的に困難だったAIアプリケーションを実用化できる可能性を開きます。同時に、電力効率やサステナビリティの観点からも、インフラ選択の重要性が増しています。

【用語解説】

Tensor Processing Unit(TPU)

Googleが開発したAI専用のカスタムプロセッサ。行列計算を高速に処理することで、機械学習モデルの訓練と推論を効率化する。第7世代のIronwoodが最新版である。

推論(Inference)

訓練済みのAIモデルを使用して、実際の入力データに対して予測や応答を生成するプロセス。チャットボットやAI検索が何かに答えるときの処理が推論にあたる。トレーニングと異なり、低レイテンシと高い信頼性が求められる。

Inter-Chip Interconnect ネットワーク

複数のプロセッサを高速で接続するための通信基盤。Ironwoodの場合、9,216個のチップを1秒あたり9.6テラビットの速度で相互接続し、一つのスーパーコンピュータとして機能させる。

High Bandwidth Memory(HBM)

プロセッサのすぐそばに配置された、非常に高速なメモリ。Ironwoodでは1.77ペタバイト(大型映画館を数百年分分量できるくらいの容量)のHBMが実装されている。

Optical Circuit Switching(OCS)

光を使って動的にネットワークトラフィックを再ルーティングする技術。障害発生時にシステムを再起動せず、自動的にデータの流路を変更して稼働を継続させる。

Arm ベース CPU

従来のIntel/AMD系x86プロセッサではなく、スマートフォンに採用される省電力なArmアーキテクチャを採用したサーバー用プロセッサ。Google Axionはこれに該当する。

ExaFLOPS

コンピュータの演算性能を示す単位。1 ExaFLOPS は1秒間に100京回の浮動小数点演算を行える。FP8はより低精度(8ビット)で計算する方式で、高速化とメモリ削減が可能。

推論ゲートウェイ(Inference Gateway)

複数のサーバーに分散したAIモデルへのリクエストを最適に振り分けるシステム。KVキャッシュヒットやレイテンシを考慮して、同じ文脈を持つリクエストを同じサーバーに送り、計算の無駄を削減する。

KV キャッシュ

会話型AIが以前の文脈を記憶しておくためのメモリ領域。効率的に共有されることで、レスポンスタイムの短縮と処理コストの削減につながる。

【参考リンク】

Google Cloud(外部)

Googleが提供するクラウドコンピューティングサービス。エンタープライズ向けのAI・機械学習ソリューション提供。

Anthropic(外部)

Claude言語モデルを開発・提供するAI安全企業。Googleとのパートナーシップでインフラを活用。

Google Kubernetes Engine(外部)

マネージドKubernetes環境。大規模分散AIワークロードの管理に用いられるプラットフォーム。

Open Compute Project(外部)

Meta、Google、Microsoftが参加するオープンソースハードウェア財団。データセンター設計の標準化を推進。

MaxText(外部)

GoogleがGitHubで公開するオープンソースAI訓練フレームワーク。TPU上の最適化や微調整に対応。

【参考動画】

【参考記事】

Anthropic to Expand Use of Google Cloud TPUs and Services(外部)

AnthropicとGoogleの契約内容の公式発表。100万チップのアクセス権などを記載。

Google and industry leaders collaborate on 400V power delivery for data centers(外部)

Google、Meta、Microsoftが開発する高電圧直流配信システムについての詳細記事。

Anthropic expands use of Google Cloud TPU chips(外部)

Anthropicの契約詳細と業界アナリストの予測を報道。

【編集部後記】

あなたが今使っているAIサービスの応答速度や価格は、実は見えない場所での「インフラ選択」で大きく変わります。Googleがカスタムチップに投資するのは、AIを誰もが使える世界にするためかもしれません。一方で、推論処理のコスト削減は、新しいAIアプリケーションを生み出す可能性も秘めています。テクノロジーが美しく、暮らしに寄り添う形で実装されるには、こうした基盤がどう組まれるのかが実は重要なのです。次にあなたが何か新しいAIサービスを試すとき、そのバックに何があるのか、ちょっと想像してみませんか。